定制垂类大模型 = 优质数据集 + 开源大模型

我们微调的目的,是定制一个专属的垂类大模型,实现这一点,需要我们所指定领域的优质数据集和一个选定的开源通用大模型

通俗来说, 微调 ,其实可以类比为给一个 高中生 ( 通用大模型 ),灌输 知识偏好 (数据集)塑造世界观,长大成 职业选手 (分化成对应的能力者, 垂类大模型 )。

1.1 收集可能的数据集素材

Chat-嬛嬛这种赋予大模型特定人格的技术,也被称为 大模型的人格化,它是指通过一系列技术手段,使大模型在 语言表达、行为模式、情感反应 等方面更接近人类,从而为用户带来更自然、更亲切、更个性化的 交互体验 。

要想实现这个目标,我们其实就是要让AI在对话中,能按照一问一答的方式,回复出对应人物风格的话语,最简单我们能思考到的,就是把相关的台词都喂给AI,因此我们可以去网上搜集相关的剧本。

1.2 构建对应格式的数据集

1.2.1 选择数据格式

对于语言模型来说,微调数据必须是文本。如果你的数据源是WORD、PDF等格式,需要使用专门的解析工具,提取其中的文本。如python的docx、PyPDF2包。

其次,微调数据除了当前对话的输入和输出之外,还有一些其他的属性,如想要大模型扮演的角色、对话历史等等。因此,为了更好地对数据进行处理,通常会对数据进行结构化,并以json或者jsonl的格式进行存储。

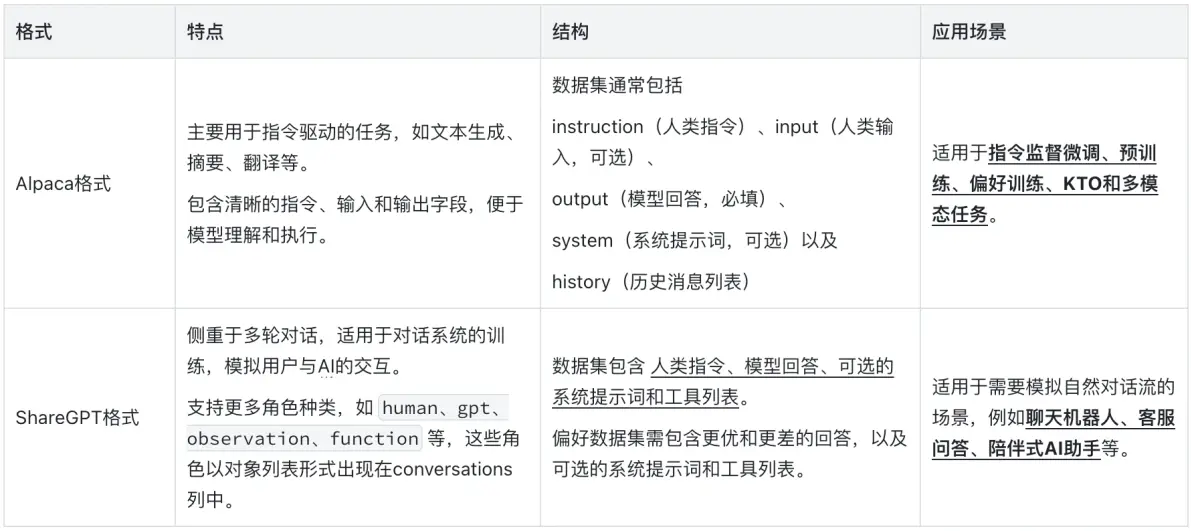

具体来说,目前主流的数据集有两种格式: Alpaca 格式和 ShareGPT 格式,其主要特点如下表所示。

1.2.2 构建数据集

这里为了构建足够大的数据集,我直接将instruction和output分为了subject、verb、object以及其他的一些助词,直接通过代码枚举组合生成了足够的数据

1.3 配置微调参数

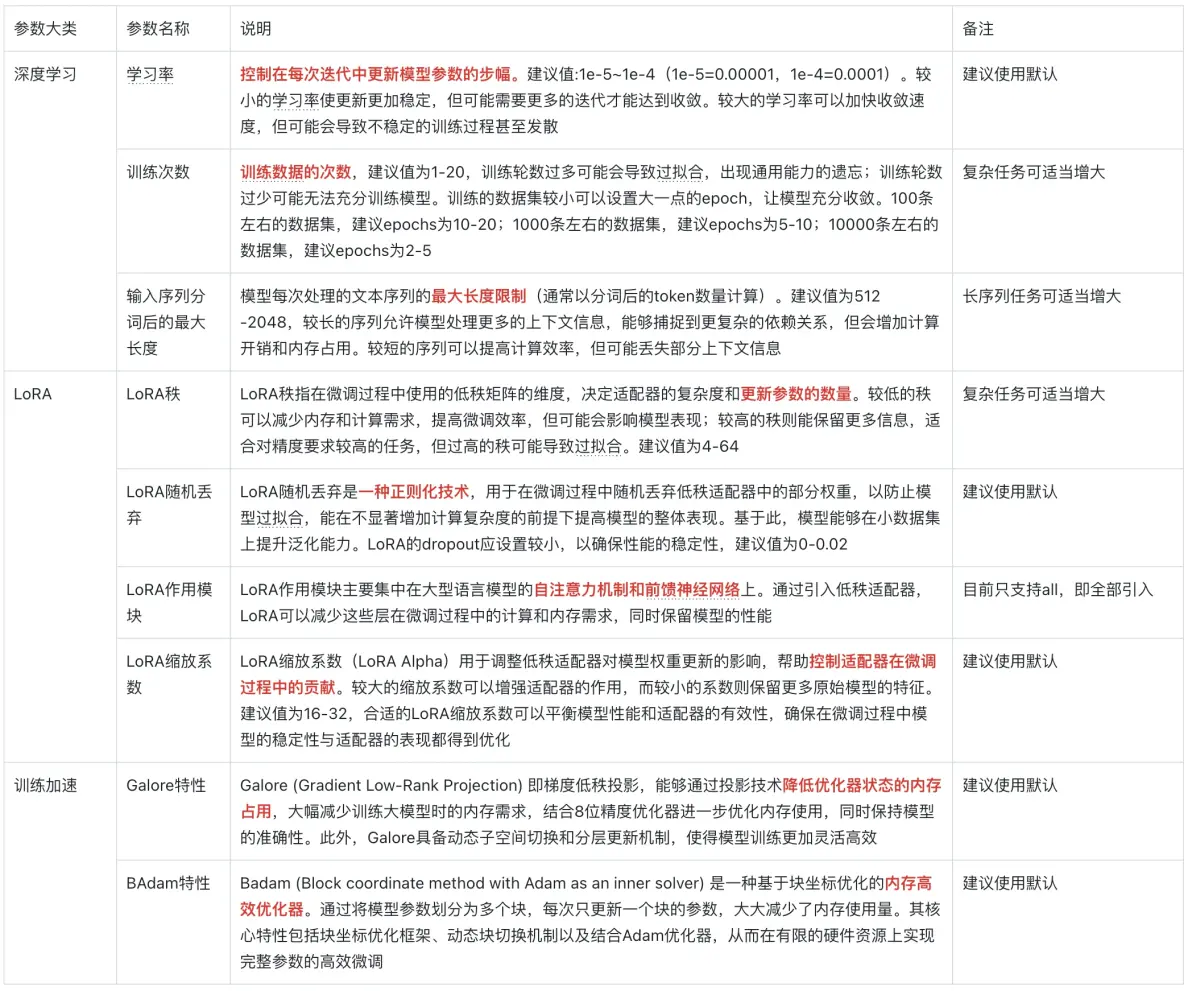

在讯飞星辰MaaS平台,可支持配置的微调参数可以分成下面三个大类。

1.4 评价微调效果

模型训练完成后,可以仿照上一篇文章一样,将模型发布为服务 ,使用简单数据进行效果验证。

如果效果符合预期,可以采用类似构建训练集的方式,构建测试集,进行 批量推理 。

最后,如果希望将模型集成在要开发的应用中,可以使用在模型服务列表,查看 调用信息 ,进行api调用。

Comments | NOTHING